Para introducir la computación cuántica es necesario entender cuáles son sus orígenes y su propósito. Podríamos entender que su nacimiento es fruto de una necesidad derivada del proceso de miniaturización de los componentes de los computadores digitales. La Ley de Moore, que determina el proceso de miniaturización de componentes, nos ha llevado a una situación en la que dichos componentes son tan pequeños y están tan próximos, que su comportamiento se rige por leyes que no pueden explicarse con nuestros cómodos principios de la mecánica clásica. Y aquí es donde entra en escena la mecánica cuántica, capaz de explicar el comportamiento dinámico del mundo microscópico.

Mecánica cuántica

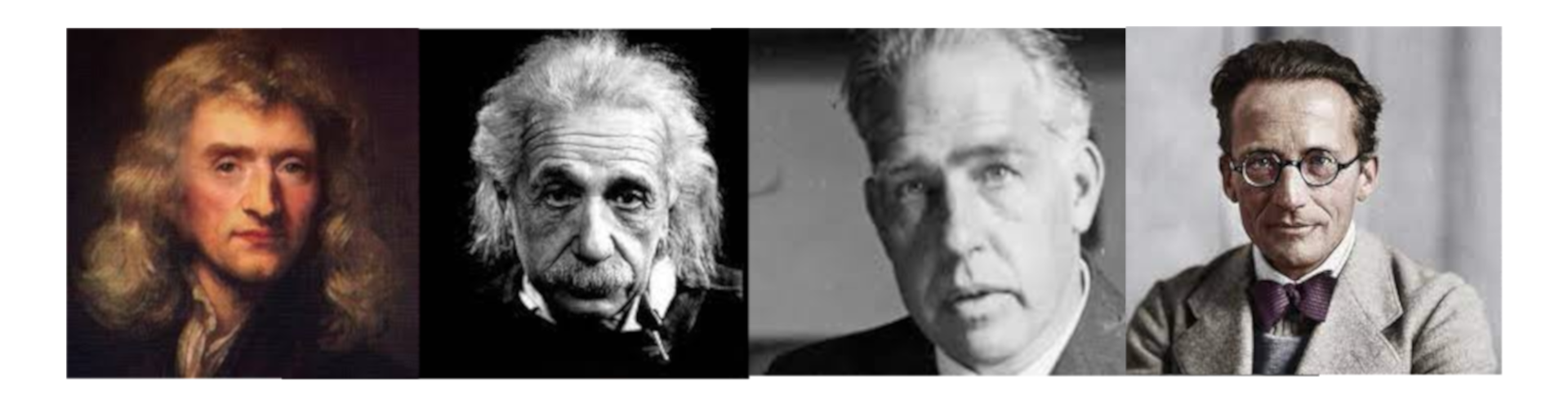

Si tuviéramos que elegir los personajes más relevantes que han contribuido al desarrollo de la mecánica cuántica sin duda tendríamos que construir una lista muy grande pero en esa lista, con independencia de quién la hiciera, seguro que estarían los 4 personajes que aparecen en la imagen. De izquierda a derecha: Isaac Newton, Albert Einstein, Niels Bohr y Erwin Schrödinger.

El primero, Isaac Newton, debe estar presente porque sin la mecánica clásica difícilmente podríamos estar hablando hoy de la mecánica cuántica. Newton sentó las bases de la ciencia para explicar cómo se comportan los sistemas físicos macroscópicos y poder predecir su comportamiento. Consiguió explicar, con ayuda de las matemáticas, el mundo determinista al que estamos acostumbrados.

Se que, en este momento, pensarás, que en un mundo determinista, donde cada causa crea un efecto necesario, no tiene cabida el libre albedrío y tendrías, en parte, razón. Y digo “en parte” porque no creo que el propósito de Newton fuera entrar en este debate, en sus tiempos relegado al campo de la filosofía, sino más bien explicar el mundo tal y como lo vemos.

En cualquier caso, aquí es donde ciencia, filosofía e incluso religión, compiten por explicar la verdad que rige nuestro universo pero, obviamente, tal debate no es el objeto de este artículo. A los que les interese esta reflexión y quieran pasar un rato entretenido, les recomiendo que vean la miniserie de televisión DEVS, de Alex Garland.

Luego cuando hablamos de determinismo, o universo determinista, nos referimos al comportamiento del mundo macroscópico, del mundo que observamos, pero eliminando al agente, al Yo, de la ecuación. La grandeza de Newton es que nos enseñó a entender el mundo que observamos con ayuda de las matemáticas, a predecir los efectos a partir de sus causas.

Y el mundo fué predecible y cómodo. Habíamos explicado las reglas fundamentales que rigen su comportamiento. Pero todo esto cambió cuando empezamos a observar los objetos muy pequeños (o también los muy grandes). Cuando el avance tecnológico y científico nos abrió las puertas a los componentes de toda la materia, a los átomos, comenzaron nuestros problemas. En ese momento nos dimos cuenta que, aunque las leyes de Newton funcionaran correctamente en la mayor parte de los sucesos del mundo que observamos, no lo hacían para el mundo de las cosas muy chiquitas, para el mundo atómico o subatómico.

El primer modelo atómico, el modelo de Rutherford, intentaba explicar el átomo aplicando las leyes de la mecánica clásica y las ecuaciones de Maxwell del electromagnetismo, pero el resultado era un modelo inestable, contrario a lo observado. Fué Niels Bohr quién, en 1913, propuso su propio modelo atómico, en el que introdujo el término de cuantificación de la energía que luego ha dado nombre al modelo actualmente aceptado de dinámica de la materia microscópica: la mecánica cuántica.

Poco podemos decir de Einstein que no hayamos oído ya. Sin embargo, resultan curiosos ciertos detalles que suelen pasar desapercibidos. No cabe duda de que Einstein fué uno de los mayores genios de la historia de la ciencia y su teoría de la relatividad general y especial, sintetizadas en su famosa fórmula E=mc2, es algo que casi cualquier persona conoce. Sin embargo, Einstein no recibió el premio Nobel por su trabajo en dichas teorías, sino por su explicación del efecto fotoeléctrico que, por otro lado, fué fundamental para plantear la dualidad onda-corpúsculo de la materia microscópica, y por la postulación del fotón como partícula de energía asociada a la luz, ambas decisivas en el desarrollo de la física cuántica.

Otro dato paradójico sobre Einstein es que, pese a ser uno de los mayores científicos de la historia, nunca estuvo de acuerdo con algunos de los postulados de la mecánica cuántica o algunos de sus resultados experimentales. La frase famosa de Einstein “Dios no juega a los dados” fué parte de su acalorada discusión con Bohr sobre la naturaleza dual de la materia microscópica y su discrepancia con la interpretación probabilística de la mecánica cuántica (interpretación de Copenhague), en la que se postulaba que todos los estados cuánticos son posibles y el acto de medir, u observar, hacía colapsar la función de onda en un determinado valor, según parecían demostrar los experimentos. En otras palabras, la realidad sólo existe cuando se observa. También resulta curioso que la respuesta de Bohr a Einstein: “Deja de decirle a Dios cómo usar sus dados”, no ha perdurado en la memoria colectiva.

Einstein tampoco estaba de acuerdo con el concepto del entrelazamiento cuántico que podría poner en duda el límite relativista universal de la velocidad de la luz, que implicaba la existencia, según sus palabras, de una “fantasmagórica acción a distancia”, y que pondría en riesgo el principio de causalidad. Si muchos conceptos relacionados con la mecánica cuántica resultan contraintuitivos a nuestra percepción del mundo real, no quiero pensar en un mundo, ni puedo imaginarlo, en el que los efectos preceden a las causas.

Estas dudas fueron plasmadas en un experimento mental planteado a Bohr por Einstein y sus dos colegas, también físicos, Podolsky y Rosen. Este ejercicio mental ha pasado a la historia como la paradoja Einstein-Podolsky-Rosen o paradoja EPR, que concluyó con el planteamiento de Bohr del entrelazamiento cuántico. Jamás llegaron a entenderse y Einstein falleció manteniendo sus dudas sobre ciertos postulados de la mecánica cuántica.

Años después de este debate (en 1965), el físico John Bell planteó la desigualdad que lleva su nombre, según la cual se postuló que se podría diseñar un experimento que determinaría quién tenía razón. En 1982, el físico francés Alain Aspect creó dicho experimento y demostró, de una vez por todas, que Bohr tenía razón desde el principio.

Si Newton consiguió postular de una forma brillante la mecánica clásica permitiéndonos poder predecir el comportamiento de un objeto en función de sus condiciones iniciales, Schrödinger hizo lo propio con las partículas atómicas. La belleza de su formulación es indudable. Históricamente el desarrollo del modelo atómico de Bohr junto con la dualidad onda-corpúsculo permitiría a Schrödinger descubrir la ecuación fundamental de la mecánica cuántica.

Computación Cuántica

Podemos entender, en esencia, que la mecánica cuántica explica el mundo de las cosas chiquititas y que la mecánica clásica es una simplificación útil cuando estudiamos objetos macroscópicos, formados por miles de millones de átomos, en cuyo caso no es posible resolver las ecuaciones para todas las partículas y sus interacciones. Pero ¿qué tiene que ver esto con la computación?

En primer lugar, como mencionaba en la introducción, la miniaturización de los componentes electrónicos, da lugar a que se manifiesten ciertos efectos que sólo tienen explicación con la mecánica cuántica, cuyo conocimiento es necesario para construir estos dispositivos y que funcionen según lo esperado.

Sin embargo esto no ha sido, al menos de forma aislada, fundamento para el nacimiento de la computación cuántica. La idea de computación cuántica es relativamente reciente. Surge en 1980, cuando el físico Paul Benioff propuso un modelo cuántico de la máquina de Turing.

Una máquina de Turing es un dispositivo que manipula símbolos sobre una tira de cinta de acuerdo con una tabla de reglas. A pesar de su simplicidad, una máquina de Turing puede ser adaptada para simular la lógica de cualquier algoritmo de computador y es particularmente útil en la explicación de las funciones de una CPU dentro de un computador. Originalmente fue definida por el matemático inglés Alan Turing, en 1936, como una «máquina automática», como un dispositivo hipotético que representa una máquina de computación y que ha sido la base del desarrollo de las ciencias de la computación y la fabricación de los computadores que conocemos.

El modelo teórico propuesto por Benioff, y posteriormente desarrollado, entre otros, por Richard Feynman y Peter Shor, ha dado lugar a un nuevo paradigma de computación basado en los fenómenos cuánticos y al desarrollo de la computación cuántica.

Sin embargo, para entender la computación cuántica, creemos que lo más sencillo es compararla con la computación clásica a la que estamos acostumbrados. Para ello introduciremos conceptos básicos de la teoría de la computación clásica y la estructura de un computador, para luego entender las diferencias en el nuevo paradigma de la computación cuántica.

En el siguiente artículo de esta serie, |QC-2> Von Neumann le abre la puerta a Mr. Bit, explicaremos el funcionamiento de un computador digital, sus fundamentos teóricos y sus orígenes, antes de continuar con su equivalente cuántico.

Otros artículos de esta serie:

- |QC-1> El mundo de las cosas chiquititas

- |QC-2> Von Neumann abre la puerta a Mr. Bit

- |QC-3> Todo es ahora muy distinto

- |QC-4> Encendiendo los fogones

- |QC-5> Puchero de átomos

- |QC-6> La mesa está puesta

- |QC-7> ¿Qué hay de postre?